HBM,何以成为AI角力关键?

2025.10.23

三星电子近日宣布,其12层第六代HBM4内存将于10月底正式发布,现已进入研发冲刺阶段,并计划今年晚些时候量产。这一动作无疑为2025年本就爆发式增长的HBM市场再添一把烈火。

为什么HBM年增速能突破200%,达到68亿美元全球市值,成为AI赛道的"战略石油"。 今天,超集信息带您透视HBM的底层逻辑:从打破"存储墙"到决定大模型训练速度,它如何悄悄掌控AI算力的生死线。

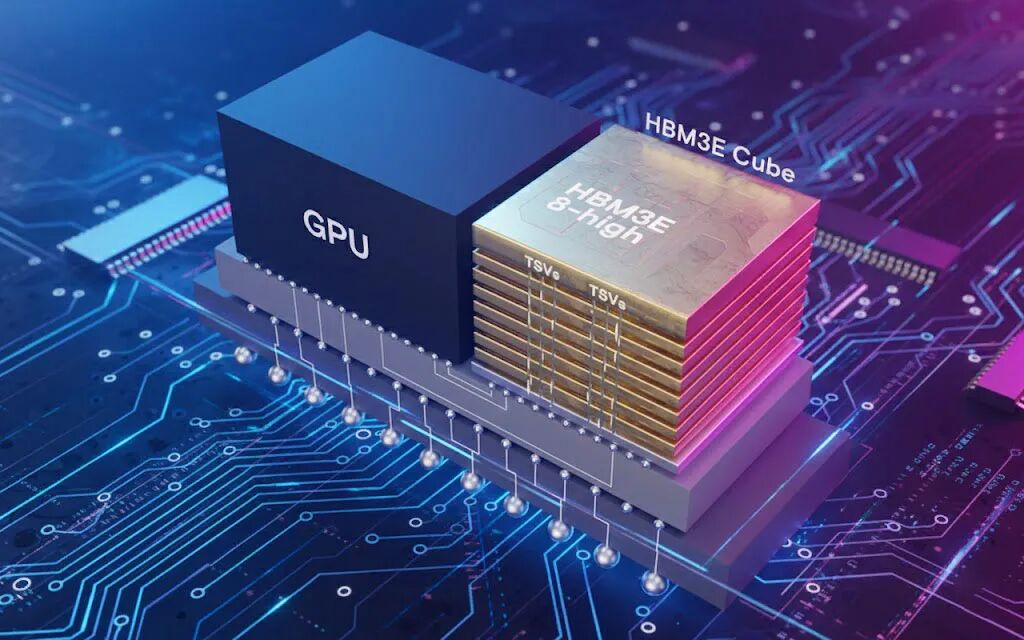

HBM对GPU的性能提升,本质是解决了传统内存(如GDDR6、DDR5)的"带宽瓶颈"——GPU计算核心的算力(如 FP8 算力达 1-2 PFLOPS)已远超内存数据供给能力,导致 "算力闲置"(GPU 等待数据加载)。HBM通过三大技术升级打破这一桎梏:

带宽革命性提升

Bandwidth

当下的HBM3E,采用12层(部分厂商已实现14层)3D堆叠工艺,单颗裸片带宽达1.2TB/s(HBM3 为0.8TB/s),单栈容量提升至24GB(HBM3为16GB)。当下旗舰GPU通常搭载8栈HBM3E,总带宽达5-6TB/s(较HBM3提升约24%),是GDDR6的4-5倍(GDDR6单卡带宽约 1-1.5TB/s)。

这意味着GPU每秒可读写5-6TB数据,足以匹配其万亿次级的计算能力,从"计算等数据"变为"数据追计算"。

容量&带宽协同优化

Memory

当前,通过HBM3E技术,NVIDIA将旗舰GPU显存堆叠至192GB,下一代产品Rubin更将基于HBM4提升至惊人的288GB。大显存配合高带宽,使GPU可直接加载更大的模型参数(8卡单机即可实现百亿模型的完整加载)、更高分辨率的特征图(如8K图像的1024通道特征图约32GB),避免传统"数据分块"导致的30%-50%效率损失(分块需额外计算边界填充、参数同步)。

能效比结构性优化

Energy

HBM3E通过TSV(硅通孔)技术缩短数据传输路径,每GB带宽功耗降至0.3W(HBM3为0.4W,GDDR6为0.8W),同等带宽下功耗降低25%-50%。这使GPU在相同散热条件下可维持更高的Boost频率,进一步放大算力输出。

1、 AI 大模型训练:25%-50%的效率提升

大模型训练的核心瓶颈是"参数与特征图的实时传输",HBM3E的高带宽直接减少"数据等待时间":

· 千亿参数模型(如Llama 3 70B):141GB HBM3E GPU训练时,单卡每轮迭代时间从80GB HBM3 GPU的180秒压缩至120秒,效率提升33%;若采用8卡系统,因HBM3E的NVLink协同带宽更高(900GB/s),集群效率从82%提升至91%,总训练周期缩短40%。

· MoE 混合专家模型(如GPT-4 MoE):MoE的稀疏激活特性需频繁读取不同专家层参数,HBM3E的1.2TB/s 单栈带宽使专家切换延迟从HBM3的80 μs降至50μs,单卡吞吐量提升25%,同等算力下可支持的专家数量从64扩展至128。

2、高分辨率视觉处理:30%-60%的速度跃升

高分辨率图像/视频处理(如8K分割、3D医学影像重建)对"大尺寸特征图读写" 需求极高,HBM3E的大容量+高带宽可避免分块处理:

· 8K图像分割(如卫星遥感影像):处理1张7680×4320的图像时,ResNet-152 模型的特征图需占用约48GB显存,HBM3(128GB)需分2块处理(额外耗时30%),而HBM3E(192GB)可单块处理,端到端时间从120ms压缩至70ms,提升42%。

· 3D医学影像重建(512×512×512体素):3D U-Net 模型的中间特征体素需占用64GB显存,HBM3因容量不足需分8个子块(误差累积+分块耗时),而HBM3E可全量加载,重建精度从92%提升至95%,同时速度提升58%(从5分钟压缩至2分钟)。

3、多模态实时推理:20%-35%的延迟降低

多模态推理(如文本-图像生成、自动驾驶感知)需同时处理异构数据(文本token、图像像素、点云坐标),对带宽实时性要求苛刻:

· Stable Diffusion XL图像生成(1024×1024):生成1张高清图像需加载文本编码器(3GB)、图像解码器(8GB)、交叉注意力层(5GB),HBM3E的高带宽使数据加载延迟从HBM3的150ms降至90ms,单图生成时间从2.5秒压缩至1.8秒,提升28%。

· 自动驾驶BEV感知(11路4K摄像头+激光雷达):每秒需处理1.2GB数据(图像+点云),HBM3E的5.3TB/s 带宽可实现数据"零等待",感知延迟从HBM3的80ms降至50ms(满足L4级自动驾驶的安全阈值),同时目标检测准确率提升3%(减少数据截断导致的特征丢失)。

4、科学计算:15%-40%的算力利用率提升

计算流体力学(CFD)、分子动力学等科学计算依赖 "大规模矩阵运算 + 中间结果读写",HBM3E的带宽可提升算力利用率:

· 分子动力学模拟(100 万原子体系):每步模拟需读写8GB原子坐标与力场数据,HBM3E的带宽使数据IO时间从HBM3的200ms降至120ms,GPU算力利用率从65%提升至85%,单日模拟步数从1200步增至1800步,提升50%。

HBM技术与GPU结合后带来的性能跃升,本质是"算力-带宽"匹配度的质变:在数据密集型场景中,综合性能提升20%-50%,部分场景突破100%;更重要的是,它打破了内存对GPU算力的"封印",让GPU的万亿次计算能力真正落地为实际业务效率的提升。对于AI大模型、高分辨率视觉、科学计算等前沿领域,HBM3E已不是"可选配置",而是决定GPU能否参与下一代算力竞争的"刚需门槛"。