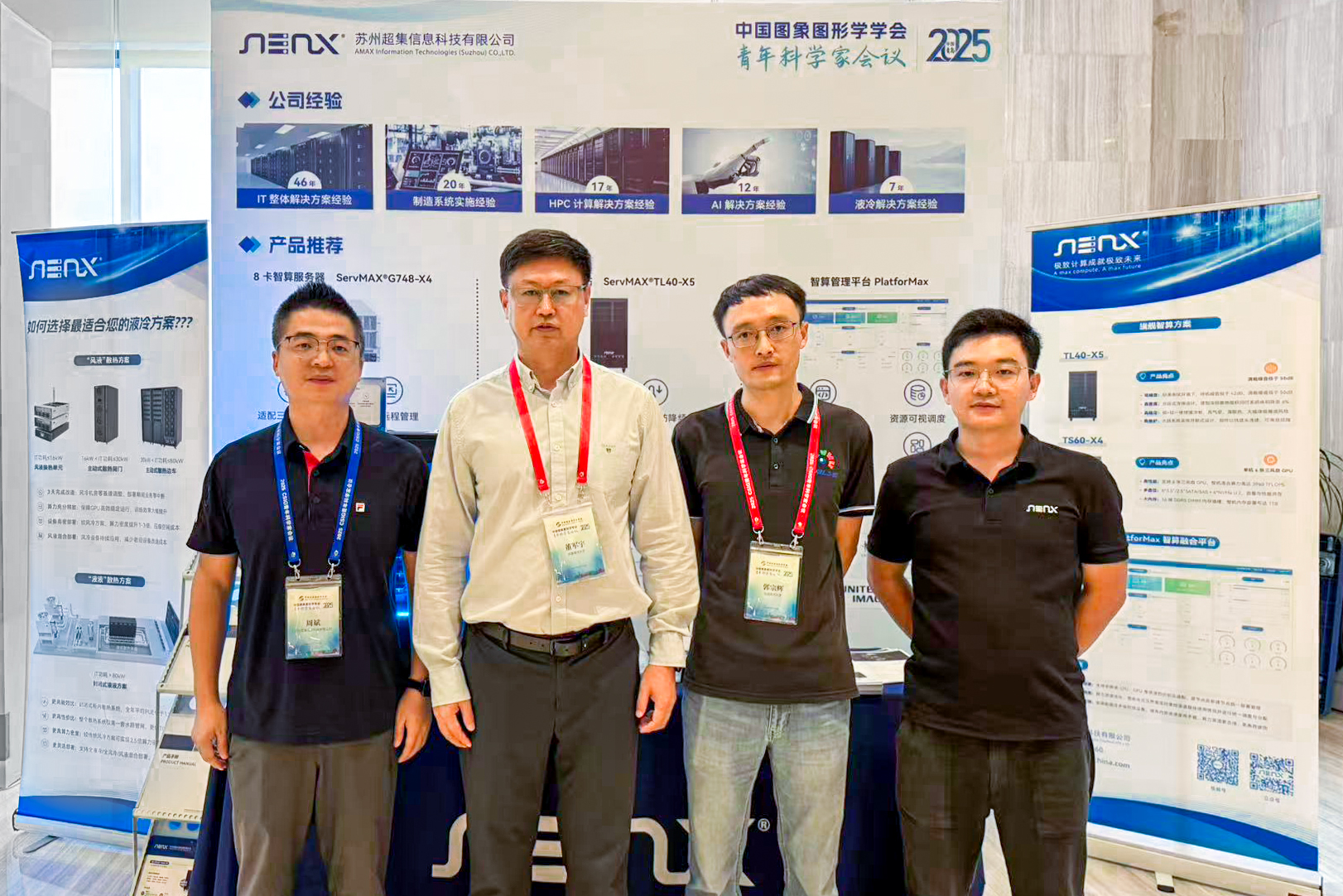

超集信息重磅亮相2025 青科会!硬核算力+案例实践,赋能图象图形学持续创新

2025.09.22

作为全球领先的算力解决方案提供商,超集信息(AMAX)受邀出席此次大会,带来从桌面研发到数据中心级训练的前沿算力解决方案展示与分享,得到大会主席董军辉、委员会主席郭宗辉的高度认可,为图象图形学研究与应用注入新动能。

超集信息基于海量项目实践经验,探索出CV领域通用需求,并以液冷工作站系列解决方案针对性破局——算力稳定、高效静音、便捷部署。同时,平台x86与国产"芯"双轮驱动,全面拥抱国产化。

· 30℃环温12H压测,CPU低于80℃,GPU低于77℃,较风冷降温20%

· 3000W功耗下,待机噪音约45dB,满载噪音约55dB,较风冷降噪15%

· 水箱、水泵、冷排等组件一体式集成,开箱即用

· 全面兼容m-ATX/ATX/E-ATX/15" x 13"等主流尺寸主板,为用户提供更多样化选型

· 无缝适配X86、ARM两大主流架构平台,深度优化飞腾、海光、昇腾等国产高性能计算平台支持

· 高效兼容GPU、NPU、DPU等多种类型加速卡,显著提升特定负载处理效能

清华大学

多模态分析

1、CLIP+LLM 联合训练,单卡80 GB显存仍报OOM——因为4亿图文对embedding需同时驻留。

2、文本最大长度4k tokens,batch=8时峰值显存>94 GB,GPU崩溃成家常便饭。

3、多机并行采用NCCL AllReduce,万兆以太网延迟200 μs,梯度同步慢,GPU利用率掉到45%。

根源问题

"大模型+大数据"对显存容量与跨机带宽同时提出线性以上需求,传统PCIe互联&以太网成为瓶颈。

超集方案

· 内存统一:通过采用更大的一致性内存,embedding表自动溢出到CPU侧,GPU逻辑显存进一步扩展,OOM彻底解决。

· 计算-通信重叠:NVLink Switch支撑下,AllReduce延迟<5 μs,梯度传输与反向计算overlap,GPU利用率回升到92%。

· 编译优化:使用NVIDIA Transformer Engine,FP8精度训练,显存占用再降 50%,吞吐量提升2.4 倍,3天完成原先10天的CLIP大模型预训练。

浙江大学

病理精准检测

1、千兆像素病理切片单文件>3 GB,传统单机无法全片加载,只能分块(patch)推理,细胞级小目标跨patch被切割,漏检率15%。

2、分块后I/O风暴:4×GPU同时读取,NAS带宽打满40 Gbps,patch排队加载,GPU空转60%时间。

3、H&E染色差异大,需在线Stain Normalization,计算密集,单卡处理一张WSI 需3小时。

根源问题

"超大图像+小目标+染色差异"三重挑战,显存容量、I/O 带宽、计算并发缺一不可。

超集方案

· 大显存+统一内存:48GB GPU×4,NVLink 112 GB/s,整张WSI一次载入显存,取消patch切分,漏检率降至0.8%。

· GPU-Direct Storage:绕过CPU,3 GB切片6秒直达显存,I/O 等待缩短80%,GPU利用率提升至94%。

· Stain Norm CUDA Kernel 硬化:在线染色归一化<30 ms/视野,配合FP16推理,单 WSI 全流程30分钟完成,1 小时内拿到 AI 初筛结果,复核工作量减半。

三天会期、二百余场高水平报告、千余名青年学者与产业精英的密集碰撞,让"智能、绿色、开放"成为图象图形领域新的关键词。思想的火花已点燃创新的引擎,未来,超集信息将继续与学会、高校及科研机构并肩前行,以可持续算力助推中国图象图形学科攀登下一座高峰。