解禁+13 倍碾压!NVIDIA H200 性能终极揭秘!

2025.12.10

美东时间 12 月 8 日,重磅消息引爆 AI 圈!美国总统特朗普通过社交媒体官宣:允许英伟达向中国等市场"经批准客户"出口 H200 AI 芯片(附带国家安全条件,细则由美国商务部落实)。

作为当前全球性能第二强、且唯一对华可及的旗舰级 AI 芯片,H200 的实力到底有多能打?和 H100、H20、B200 的核心差距又在哪?

性能暴击

显存与速度双飞跃

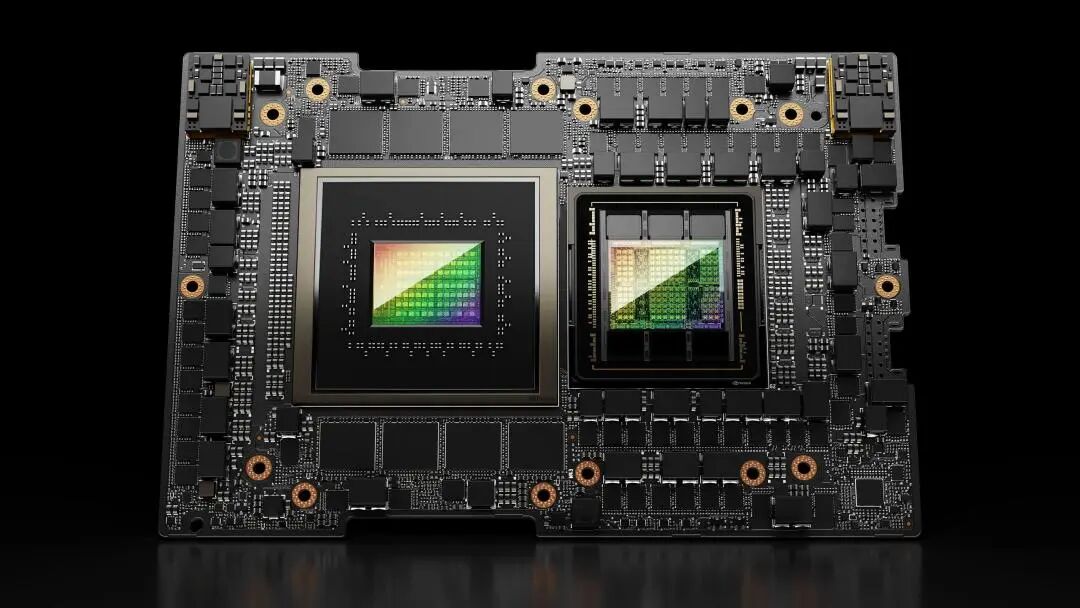

H200 搭载台积电 4nm 工艺,延续 H100 的 700W 功耗,在AI 大模型最关键的"内存 + 带宽"上实现颠覆性升级,核心算力与 H100 持平却更适配复杂任务:

· 显存容量:141GB HBM3e(较H100 的 80GB 暴涨 76%),再也不用为大模型"内存不够用"发愁;

· 显存带宽:4.8TB/s(较 H100的 3.35TB/s 提升 43%),数据传输效率飙升,减少任务等待时间;

· 核心算力(FP8):3958 TFLOPS(较 H20 跃升 13倍),配合超大显存,大模型推理速度直接比 H100 快 2 倍!

参数对比

透视H200的升级与定位

场景抉择

H200的核心优势

1、对比H100:老用户的无缝升级与性能红利

对于已部署H100计算集群的用户,H200是最高效的升级路径。两者算力持平,平台完全兼容,更换后无需重构基础设施。其带来的141GB HBM3e超大内存,能将1750亿参数模型完全容纳于单卡,推理速度较H100提升近2倍,直接缩短任务周期,提升计算资源利用率。

2、对比B200:务实之选与”空中楼阁”的权衡

B200基于新一代Blackwell架构,是面向万亿参数时代设计的性能怪兽。但其惊人的1000W功耗和全新的平台需求,意味着高昂的总体拥有成本与基础设施重建,而H200在性能、功耗、成本与平台兼容性间取得了绝佳平衡。

最重要的是,B200仍处于禁售状态,再高性能的"空气卡",于用户而言也不过是"空中楼阁"。

3、对比H20:代际之间的绝对性能鸿沟

H20的定位是满足合规市场的基础AI算力需求。与H200相比,其算力仅有约1/13。这不仅是参数的差距,更是应用场景的代际差异:H20适用于模型微调、中等规模推理;而H200则能驾驭全参数大模型训练、复杂科学计算等前沿重任。

﹀

﹀

﹀

终极结论:H200 是未来 1-2 年 AI 市场 "主力王"

· 性能平衡:700W 功耗下,兼顾算力、内存、带宽,完美适配大模型训练 / 推理、复杂数据处理等核心场景;

· 成本可控:无需重构现有服务器平台(兼容H100 生态),升级成本低,企业易落地;

· 关键优势:对华不禁售!是当前唯一能合法获取的旗舰级 AI芯片,解决了"有需求买不到"的行业痛点。

想解锁 NVIDIA H200 全套解决方案?想了解具体应用场景的实测表现?立即联系NVIDIA Elite Partner「超集信息」,我们的专业团队将为您量身定制专属方案!超集信息愿与您一起,以极致计算成就极致未来!